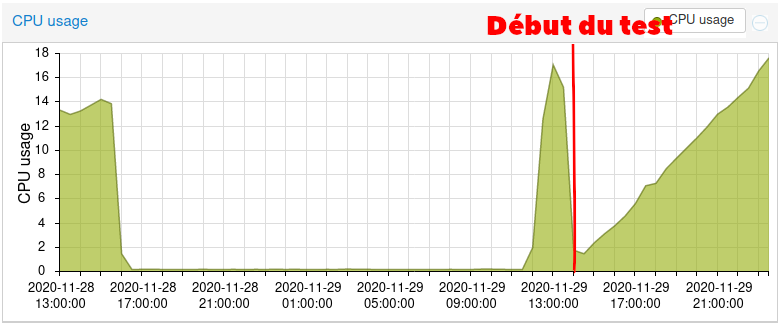

Avec les copains du Canard Réfractaire, à l’occasion de l’université confinée que l’on organise, nous avons fait un premier test de la fonctionnalité Live sur un serveur de développement.

Voici les retours de l’administrateur :

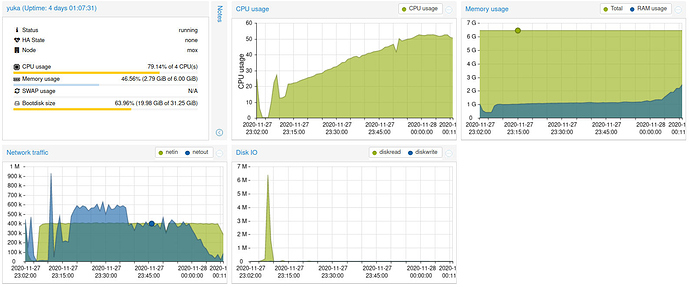

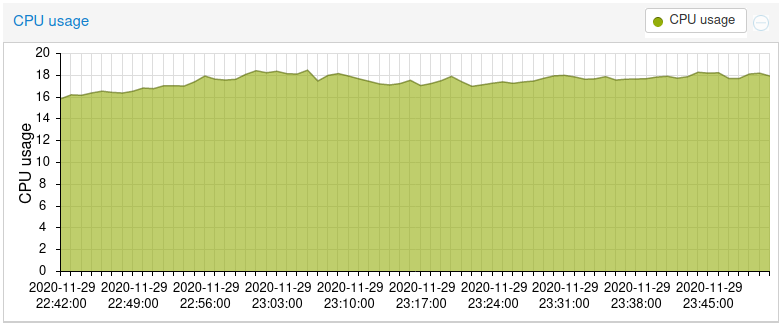

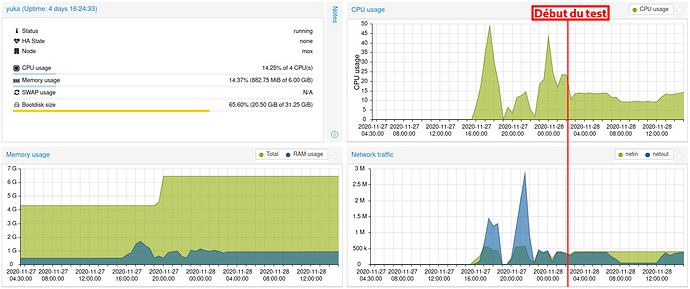

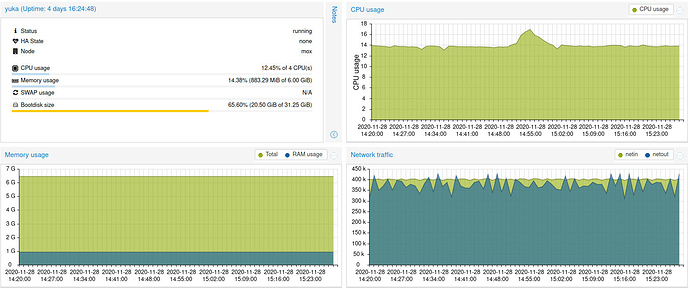

Mes conclusions suite a ce premier test : On à streamé en live sur peertube pendant 1h40. Je crois qu’on était une grosse dizaines de personnes a regarder le live au pic de fréquentation. Et vu les consommations de ressources faut pas esperer dépasser une quinzaine de personnes sur la bande passante réseau de mon serveur de test :

- Quand on ne streame que la voix et l’écrit vocal ca ne consomme pas trop de bande passante.

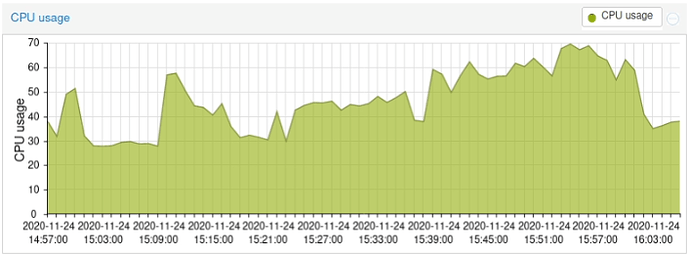

- Mais dès qu’on a essayé de streamer une vidéo c’est vite monté a 60-70% des 100Mbps de bande passante.

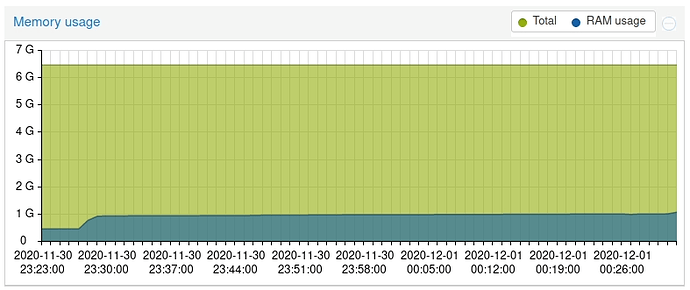

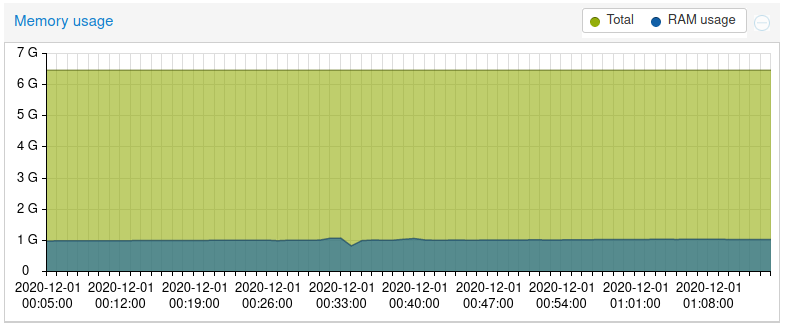

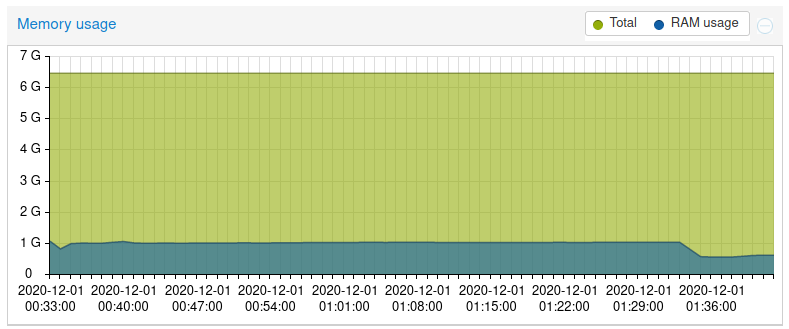

- Niveau RAM ca consommait 1.5 Go plus le cache sur les 4Go que j’y ai mis

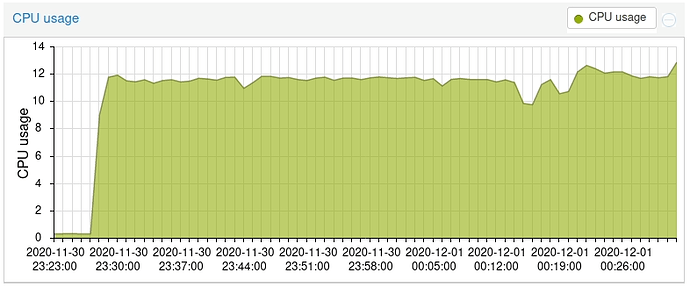

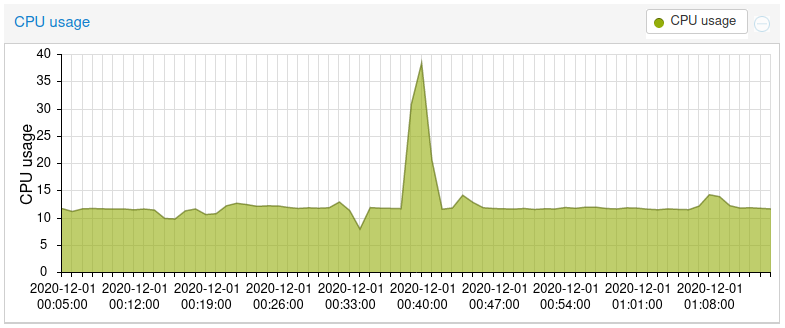

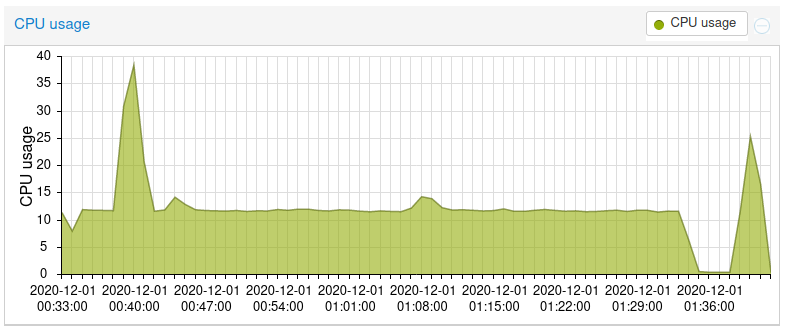

- et niveau CPU les 4 vCore que j’avais alloué à la VM étaient utilisés à 50-70%.

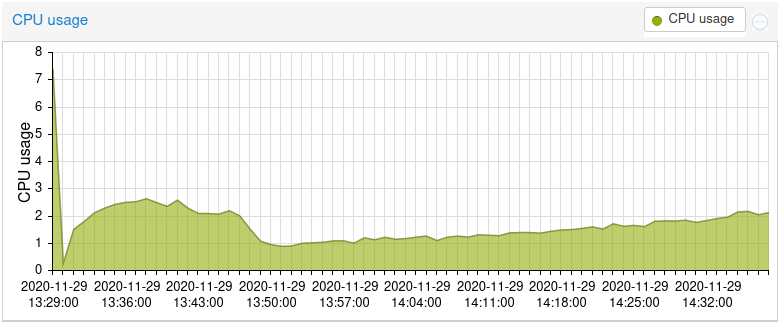

- L’utilisation CPU ne devrait pas trop augmenter en fonction du nombre de spectateurs, vu que c’est essentiellement utilisé pour le transcodage. Idem pour la RAM. La bande passante réseau par contre faut s’attendre a ce que son utilisation augmente bien. Même si le protocole p2p décharge un peu le serveur ce n’est pas fou. Les contraintes de la diffusion en live font que ca limite les bénéfices de cette technique.

Faudrait donc voir ce que ca donne sur le serveur coin (celui qui héberge canard.tube) qui lui a 10 fois plus de bande passante, enfin sur le papier, le même nombre de vCore et devrait être large en RAM avec ses 8Go même en mettant les deux instances peertube en parallèle.

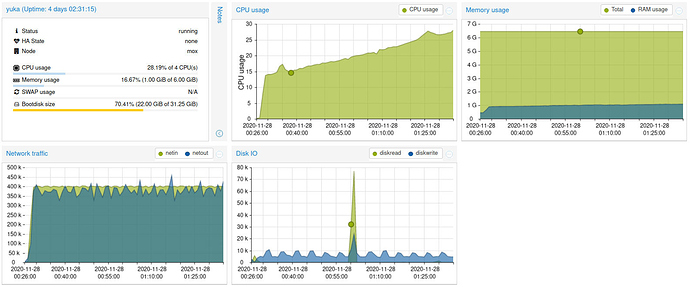

Et faudrait tester l’impact de streamer en 1080p comparé à du simple 720p qui serait peut-être suffisant. Par contre dans l’idéal il faudrait recruter plus de monde pour tester la montée en charge à un niveau plus important. Mais je ne sais pas si on peut mobiliser beaucoup plus de monde avant le jour J.Et sinon le replay à bien fonctionné donc cette fois avec le transcoding activé (en 1080p et 720p). Il consomme 5Go de disque (50,33 Mo par minutes pour pile 100 minutes de live pour être précis mais vu que ca n’a pas l’air d’être du bittrate constant ca doit dépendre de ce qu’on streame)